Вот тут -

Виртуализация: публикации + итоги опросов - делятся данными опросов читателей журнала PC Week, и сайта itblogs.ru.

По утверждению автора, на серьезную аналитику все это не тянет, однако для ознакомления интересно.

Скопипастю картинки:

вторник, 28 апреля 2009 г.

немножко аналитики

понедельник, 27 апреля 2009 г.

Ресурсы про vSphere

мне тут подсказывают пару интересных страничек про вСферу:

VMware vSphere Upgrade Center.

Посвящен обновлению до 4ки. Сразу показывают парочку внятных картинок:

Так же, доступны видеоролики по каждому из этапов.

VMware Product Podcasts. Если кто предпочитает английский на слух - на этой страничке доступны подкаcты на разные околовиСферные темы.

Одна из закладок по первой ссылке - What’s New in Licensing. Полезно для понимания изменений в лицензировании.

Еще одна закладка - What’s New with VMware vSphere 4.

Напомню, что на эту же тему, по русски, свое видение новинок описываю тут - http://vsphere.vm4.ru/new

multicore vCPU

Коллеги, уже известно, что vSphere позволит отдавать ВМ до 8 vCPU. Это хорошо. Однако, не все гостевые ОС смогут столько переварить. Например, Win2003 Standart увидит только 4. Обидно, да?

Однако, в ESX\ESXi 4 есть возможность(экспериментальная, правда) представить X vCPU не как X одноядерных процессоров, а как X ядер одного(или там x\2 ядер 2х CPU и т.д.).

Инструкция:

- Выключаем ВМ

- Заходим в "Edit Settings..."

- Выбираем "Options"

- "Advanced" -> "General"

- Выбираем "Configuration Parameters..."

- Выбираем "Add Row"

- Пишем опцию "cpuid.coresPerSocket" в столбце "Name"

- Указываем значение (2, 4, или 8) в столбце "Value"

- "OK"

- Включаем ВМ

В свойствах ВМ указано кол-во CPU для ВМ. Оно делится на число из п.7 - это число ядер, которое видит ВМ в vCPU. Полученное после деления число - это число процессоров, в каждом из которых ядер столько, сколько мы указали в п.7.

Например: для ВМ мы указали 4 процессора. Ядер на проц указали 4. ВМ видит 4\4= 1 процессор, с 4мя ядрами.

суббота, 25 апреля 2009 г.

vSphere VCP

Коллеги, про vSphere начали говорить и писать, публикуется документация, скриншоты и пр.

Вскоре ее можно будет скачать, купить.

Что по поводу обучения и сертификации VCP - VMware Certified Professional по vSphere:

Чтобы стать VCP on vSphere необходимо сдать тест по четверке.

- Если вы обладаете статусом VCP on VI3 - то до начала 2010 года вы можете сдавать тест по vSphere без дополнительных условий.

- Если вы прослушали курс по VI3, но тест не сдавали

- или сдавайте тест по VI3 - потом см.п1

- или приходите на двухдневный курс "What's New?" - мы его уже читаем(расписание). А потом можно на тест. - Если вы никто, то приходите на 4х дневный курс "vSphere - Install, Configure and Management". Потом тест.

Тест должен стать доступен примерно тогда же - т.е. в ближайшие пару месяцев актуальны только п.1 и п.2.1.

Курс What's New интересный. Несмотря на то, что для VCP его посещение не является обязательным для сдачи теста - он будет полезен.

К сожалению, вся эта информация мною получена не из официальных источников. Однако, скорее всего она верна. Как только я получу официальную информацию по этим вопросам - опубликую.

Как всегда - вопросы можно задавать на mikhail.mikheev@vm4.ru

PowerShell samples

Книжка Managing VMWare Infrastructure with Windows PowerShell: TFM.

К ней дается возможность скачать 40 скриптов примеров.

пятница, 24 апреля 2009 г.

ESX CLI scripts

ESXi и ESX отличаются наличием отсутствия Service Console в ESXi.

Ее наличие открывает широкие возможности по траблшутингу и скриптованию для ESX.

Где можно прочитать про полезные конфиги и команды:

Гайд номер раз - B2V Guide to VMware ESX Server 3. Очень всеобъемлищий источник.

Гайд номер два - VMware ESX 3.x Server and VirtualCenter 2.x Service Console Guide Ver. 1.1. Чрезвычайно полезный документик из разряда на каждый день(конечно, если связываться с CLI ESX в вашей компетенции).

среда, 22 апреля 2009 г.

Microsoft VMware Support - взгляд Майкрософт

Коллеги, к посту Вольности в толковании политик Microsoft по лицензированию и поддержке в виртуальной инфраструктуре VMware написали комментарий

- как ситуация с поддержкой выглядит со стороны MS:

Рассмотрим взгляд Microsoft?

http://www.windowsservercatalog.com/svvp.aspx?svvppage=svvpfaq.htm

“”Does the SVVP cover all Windows Server roles?

All Windows Server roles are supported with SVVP-validated solutions, except Hyper-V and Clustering Services. It does not make sense to run a hypervisor (Hyper-V) on another virtualization solution/hypervisor, and Clustering requires all of the hardware components to be tested by the hardware OEM (e.g. server, storage, HBA controller, operating system).”"

Итого - на SVVP-вадидированнх не поддерживается кластеры. НИКАКИЕ. А в Hyper-V - поддерживаются. Для поддержки кластеризации, железо должно войти в отдельный список Compatibility List (для 2000/2003), и Windows Server Catalog с ролью Clustering (для 2008) - http://support.microsoft.com/default.aspx?scid=kb;EN-US;309395

VMware там нет и не будет, извините. Значит - НИКАКОЙ поддержки решениям с использованием кластеризации в ВМ.

Продолжаем?

SVVP поддерживает ТОЛЬКО свои ОС и софт на прошедших валидацию ГИПЕРВИЗОРАХ. Читай, мы готовы поддерживать Windows Server и Exchange на ESX 3.5u3 (3.5u4 и 4.0 - увы).

Если “вдруг” вы начинаете использовать VMware Infrastructure (например HA, DRS, VMotion,..) - увы, это не гипервизор, валидации не подлежит, проблемы поддержке не подлежат - повторите на железе или идите в сторону производителя виртуализации, Microsoft вам не поможет. Для Hyper-V, очевидно, такой “проблемки” нету.

Далее?

Кто-то много говорит про Overcommitment? А кто-то в курсе, что горячее добавление памяти поддерживается только для Datacenter? Хотите поддерживаемый VDI и Server Standard? Включили Overcommitment? Забудьте о поддержке!

Закзачикам готов выслать данные рассуждения в письменном виде, заверенные юридическим отделом Microsoft.

Понимаю, что комментарии тут модерируются, - не захотим по честному, сделаю статью на несколько миллионов подписчиков TechNet/MSDN Newsletter - и там уже не будет шансов вам ответить.

С уважением, Кибкало Алексей

Архитектор, Microsoft Enterprise Services

завязалась небольшая дискуссия:

peterkd

Спасибо Алексею Кибкало за взгляд на проблему со стороны Microsoft.

Но у меня есть пара но…

1. Про роли ОС. По моему в FAQ чётко и справедливо сказано, что виртуализировать роль гипервизора смысла нет. О виртуализации гипервизора я не разу и не слышал (по крайней мере если дело не касается каких-то лабораторных экспериментов).

По поводу технологий кластеризации всё сказано в статье на KB и в ответе на вопрос Речь, насколько, я понимаю идёт, о том что для Microsoft главное, чтобы всё работало на оборудовании сертифицированном для Windows Server 2008 (что, по-моему, вполне логично). Многие наши заказчики их (технологии кластеризации) и не используют при переходе на VMware Infrastructure.

2. по поводу поддержки гипервизора и не поддержки VI. Вот убейте меня, но я никак не могу в различных статьях на сайте поддержки Microsoft найти подобных цитат. Можно точную ссылку на сайт support.microsoft.com получить, где чётко сказано, что “Если “вдруг” вы начинаете использовать VMware Infrastructure (например HA, DRS, VMotion,..) - увы, это не гипервизор, валидации не подлежит, проблемы поддержке не подлежат - повторите на железе или идите в сторону производителя виртуализации, Microsoft вам не поможет. Для Hyper-V, очевидно, такой “проблемки” нету.”

Насколько я понимаю, более чёткое прояснение данного вопроса возможно исключительно после того, как для платформы виртуализации от Microsoft будут доступны технологии, доступные заказчикам VMware в текущей версии Virtual Infrastructure Enterprise.

На самом деле, действительно, хотелось бы получить ясность и взгляд именно Microsoft, чтобы разговаривать с заказчиками по делу и основываться на фактах.

Denis Baturin

Петр,

еще несколько абзацев с ограничениями по виртуализации Exchange:

Для ведомого виртуального компьютера сервера Exchange Server выполняются условия, указанные ниже.

* На нем установлен сервер Microsoft Exchange Server 2007 с пакетом обновления 1 (SP1) или более поздней версии.

* Он развернут в операционной системе Windows Server 2008.

* На нем не установлена роль сервера единой системы обмена сообщениями. В среде виртуализации поддерживаются все роли сервера Exchange Server 2007 за исключением роли сервера единой системы обмена сообщениями.

# Microsoft Exchange Server не поддерживает динамически расширяемые виртуальные диски.

# Виртуальные диски, использующие разностные или дельта-механизмы (такие как разностные виртуальные диски или снимки Hyper-V), не поддерживаются.

Про кластеризацию от MS - с помощью VMware от нее избавиться не получиться. Поскольку HA может защитить только от сбоев оборудования. А вот Failover Cluster (aka MSCS) защищает от сбоев ОС и приложения.

Например в случае заражения вирусом или неудачно установленного обновления HA не поможет.

Эти две технологии дополняют друг друга, но HA заменить FC пока не может.

Кстати про распространенность кластеризации Exchange - в наших проектах - 6 из 10 внедрений кластеризованные. Причем последние все с Cluster Continuous Replication.

Кибкало Алексей

Пётр:

1. Относительно ЛЮБОЙ поддержки наших ОС и продуктов на сторонних гипервизорах, единственным источником является сайт программы SVVP, по которой осуществляется поддержка. SVVP явно говорит, что никакой поддержки кластеринга на других гипервихорах нет. Пётр, предлагаю направить нам запрос официально, получить официальный ответ и повесить его на сайте :)

2. Читаем выше. Все что касается наших ОС и продуктов описано на сайте SVVP, который имеет приоритет перед любыми другими источниками. Про VMotion наши заказчики задавали письменный вопрос, мы его отправляли в Редмонд, получили письменный ответ, наши юристы перевели и заверили оба варианта - русский и английский. Там сказано именно так - при возникновении проблем с ОС и продуктами Microsoft во время использования технологии VMotion данные проблемы не рассматриваются Microsoft, обращаться нужно к VMware, что разумно. Если заказчик повторит проблему без VMotion на валидированном гипервизоре, мы рассмотрим данную проблему. Модем, правда, попросить повторить на железе, если причина нам покажется в гипервизоре. Опять же предлагаю направить нам запрос официально, получить официальный ответ и повесить его на вашем сайте, такой ответ у нас уже есь и будет дан в течении рабочего дня. А вы его будете показывать по делу, разговаривая с заказчиками.

Denis:

На ваш комментарий “Про кластеризацию от MS - с помощью VMware от нее избавиться не получиться.” смотри ответ 1 выше: Если вы используете кластеризацию Microsoft в стороннем гипервизоре, вы лишены поддержки, ибо в валидированную по SVVP конфигурацию не входит Failover Clustering. Невалидированные конфигурации поддержки не имеют. Интересно, знают ли это 6 из 10 заказчиков, которым вы внедрили неподдерживаемые конфигурации?

Лично меня утомили эти юридические заковырки %)

Полмира используют виртуализацию, в основном не от MS - и всех с поддержкой посылают что ли?

У кого нибудь из читателей блога был опыт обращения в саппорт Майкрософт с проблемным софтом в ВМ не под Hyper-V?

вторник, 21 апреля 2009 г.

Про вСферу

Про вСферу:

Куча скриншотов новых возможностей - A random collection of what’s new vSphere eye candy - обязательно загляните.

Ветка официального(англоязычного) форума - VMware vSphere.

Microsoft VMware support

Коллеги, буквально вчера я писал про поддержку VMware (ссылка на русскоязычный документ), и вот сегодня пишут про поддержку Microsoft -

Вольности в толковании политик Microsoft по лицензированию и поддержке в виртуальной инфраструктуре VMware.

Дается подборка ссылок по вопросу.

vSphere is coming!

Друзья - на сайте VMware появились странички про vSphere -

VMware vSphere.

VMware vSphereTM How to Buy.

Вы уже чувствуете, что ваша жизнь изменилась к лучшему?

Что сейчас мне известно про вСферу:

Покупка будет возможна начиная с 21 мая. VI 3 будет продаваться до 21 мая, с апгрейдом до vSphere.

Картинка про разные лицензии у нас уже была: Те из них, которые со словом Essentials в названии, позиционируются для SMB. Это значит, что одна штука такой лицензии - это лицензии на 3 ESX сервера, для серверов не более чем с двумя процессорами, каждый из которых не более чем с 6ю ядрами. Плюс нужна одна штука vCenter Foundation.

Те из них, которые со словом Essentials в названии, позиционируются для SMB. Это значит, что одна штука такой лицензии - это лицензии на 3 ESX сервера, для серверов не более чем с двумя процессорами, каждый из которых не более чем с 6ю ядрами. Плюс нужна одна штука vCenter Foundation.

Остальные - Enterprise, лицензируются на процессор. Для каких то лицензий максимум 6 ядер на проц, для каких то -12. Впрочем, сегодня такое ограничение малоактуально. Ну и нужна одна штука vCenter Server.

Картинка:

Документ с подробностями - VMware vSphere™ 4 Pricing, Packaging and Licensing Overview.

К вопросу обновления VI 4 на vSphere 4:

Так же, коллеги, я потихонечку начал лабать свою записную книжку про вСферу - http://vsphere.vm4.ru.

P.S. сегодня вечером я собираюсь на российский анонс вСферы - и если есть какие то коварные вопросы про нее - могу уточнить из первых рук.

понедельник, 20 апреля 2009 г.

VMware Support

Коллеги, к вопросу о поддержке VMware - со мной тут поделились отличной ссылкой на русскоязычный документ - Руководство VMware по технической поддержке.

Из него можно узнать что из себя представляет тот или иной тип поддержки(Gold, Platinum и др.), к каким продуктам они применимы и прочее.

Дается информация о правилах поддержки и вариантах поддержки ПО Майкрософт под ESX.

Дается информация о сроках поддержки - что актуально для VI 3 в связи с выходом четверки. Процитирую:

Поддерживаемые версии продуктов VMware

Компания VMware поддерживает все версии своих продуктов с даты их выпуска до истечения 18

месяцев с момента выпуска следующей версии. Например, поддержка версии 2.x какого-либо продукта

закончится спустя 18 месяцев после выхода версии 3.0. Если будет официально объявлено о закрытии

какой-либо линейки продуктов VMware, поддержка последней версии будет осуществляться в течение

18 месяцев после объявления.

VCB GUI

Я уже писал про самопальный GUI к VMware Consolidated Backup - VCB GUI.

Еще один вариант с подоными задачами - VCB Wrangler.

Сам я с ним не разбирался, так что подробнее сказать что он может не могу.

Если кто попробует - дайте знать как оно, пожалуйста.

воскресенье, 19 апреля 2009 г.

VMware Infrustructure 3 support eol

Камрад Mister Nobody продолжает делиться интересными ссылками:

Virtual Infrastructure 3 Support Life Cycle Policy

Сколько еще продлиться поддержка(того или иного рода) VMware Infrustructure 3.

пятница, 17 апреля 2009 г.

тсссс 2

В дополнение к посту тсссс,

где были скриншоты Storage vMotion и аларомов, еще пара скринов четверки:

алармы и Host Profiles:

VMware vSphere 4 (ESX 4.0, vCenter 4.0) Alarms and Host Profiles.

snapshot search

Коллеги, напомню, что снапшоты - это зло.

Вернее, они, конечно, полезны - точка отката, все дела, но стоит забыть про сделанный однажды снапшот, и получаем:

- дополнительное занятое место на VMFS

- накладные расходы для дисковых операций - из за учащение блокировок ЛУНа в следствии более частых записей в метаданные VMFS

- дополнительное место может потребоваться для удаления снапшотов

- ВМ со снапшотами не рекомендуется мигрировать, а операции типа Storage vMotion вообще не пойдут для такой ВМ

- Мигировать ВМ ручками не рекомендуется, но можно, а из под влияния DRS такая машинка выйдет - опять же, неприятно

Но в компаниях покрупнее за создание снапшотов могут отвечать одни люди, а проблемы из за их наличия иметь другие.

Вот для упрощения жизни можно пользоваться скриптом для поиска и показа всех снапшотов - Script to Report ESX Snapshots.

vsphere.ru

Коллеги, я уверен, вы все читаете rss сайта vmgu.ru.

он открыл филиал с красноречивым названием vsphere.ru - велкам.

Дешевая, официально поддерживаемая СХД для ESX

В западных блогах наткнулся на новость об анонсе системы хранения, которая:

- занимает юнит в стойке

- способна отдать дисковые ресурсы по iSCSI и NFS

- стоит 1800$ за 2х террабайтную конфигурацию(четырехтеррабайтная на 1000$ дороже)

- и официально поддерживается VMware!

iSCSI StorCenter Pro ix4-200r.

Релиз устройства должен состоятся 22 апреля.

Видать, к выходу вСферы.

лицензирование vSphere

К вопросу о лицензиях вСферы - как вы понимаете, окончательно еще ничего не ясно, но мне подсказали вот такую картинку:

Лицензионный кошмар %)

ссылки слухи картинки

C нам продолжают делиться ссылками про вСферу.

- VMware vshield Zones

Policy-Based Network Monitoring and Enforcement for Virtual Machines

Я, кстати, для себя еще не понял - что же это такое. Кто нибудь может подсказать? - VMware Data Recovery

FAQ по этому продукту. - checklist для обновленя на вСферу.

- даташит про FT.

- thin provisioning - тонкие диски. Datasheet.

Про лицензирование:

- VMware vSphere 4 Enterprise datasheet

VMware vSphere 4 Essential datasheet

Capacity Planner

Коллеги, у VMware есть весьма неплохая штука - Capacity Planner.

C ее помощью можно проанализировать существующую Windows\Linux инфраструктуру, чтобы прикинуть как и что лучше будет виртуализовать.

"Что и как" это я так утрирую, на самом деле способов приложения анализа собираемой им информации куча - продукт очень полезен.

Можно сделать простенькое исследование, которое потребует час усилий и даст общее видение инфраструктуры, нынешней и будущей.

А можно это будущее расписать до последнего нюанса выбора железа, уровня его загрузки, необходимых фич и пр.

Доступен этот продукт только для партнеров VMware, которые затем на его основе предлагают более или менее глубокие исследования для компаний, которым это интересно.

Так вот, партнеры - можно поучиться Capacity Planner'у 23-24 апреля. Посещение курсов является входным билетом для доступа к нему.

Имейте в виду, что читается он значительно реже, чем прочие курсы VMware.

Как и на прочие курсы, заявка подается тут.

Как всегда, с вопросами не стесняйтесь - mikhail.mikheev@vm4.ru

четверг, 16 апреля 2009 г.

ссылки и слухи про vSphere

Много интересных ссылок накидал камрад, оставивший первый комментарий как Анонимный, а потом "что ж это я не представился!", и дальше писал уже как Mister Nobody:

- VMWare Roadmap 2009.

- VMware vSphere 4.

- Directions in Virtualization.

Что будет с виртуализацией в этом году, много про VDI

- VMware Data Recovery.

- VMware Virtualization for Disaster Recovery Disaster Recovery.

- Optimizing Data Protection Operations in VMware Environments.

Все надеюсь допёрли, что главный топсикрет, это

How Can I Purchase VMware vSphere?

VMware vSphere can be purchased in the following

editions:

• VMware vSphere Enterprise Plus includes the full range

of vSphere features for transforming datacenters into

dramatically simplifed cloud computing environments

providing the next generation of fexible, reliable IT

services.

• VMware vSphere Enterprise provides key features for

minimizing downtime, protecting data, and automating

resource management.

• VMware vSphere Advanced provides a strategic

consolidation solution that protects all applications against

planned and unplanned downtime to provide superior

application availability.

• VMware vSphere Standard provides an entry level

solution for basic consolidation of applications to slash

hardware costs while accelerating application deployment.

• VMware vSphere Essentials Plus provides an all-in-one

solution for small ofces to virtualize three physical servers,

reducing hardware costs while ensuring superior high

application availability and data protection.

• VMware vSphere Essentials provides an all-in-one

solution for small ofces to virtualize three physical

servers for consolidating and managing applications to

reduce hardware and operating costs with a low up front

investment

Исходя из того, что бэкапа похоже в VMware vSphere Essentials не будет и из платной поинцидентной поддержки

http://www.vmware.com/support/policies/single_incident.html

подозреваю, что VMware vSphere Essentials кандидат на бесплатность.

Игры в матрешки

Гайд, как поставит ESX\ESXi 3.5 в ВМ под Workstation есть уже давно - How to Install VMware ESX Server 3.5 on VMware Workstation 6.5 as a VM.

Появился гайд, как поставить ESX\ESXi 3.5 в ВМ подVMware Server 2.0 - How to Install ESX Server 3.5 and ESXi as a VM on VMware Server 2.0.

Разница минимальна, правда.

Hyper-V

Интересная презентация, посвященная навязшему в зубах сравнению Hyper-V и ESX - Hyper-V vs ESX at the datacenter. Комментировать не буду, кому вопрос интересен - загляните, там интересно.

Разбираются Hyper-V ver.1 и ESX 3.5, но чуток заглядывается в будущее - что добавит выход Hyper-V R2 и vSphere.

Полазав по всяким ссылкам с блога на блог, наткнулся на пост про доклад о Hyper-V на rootconf.

Процитирую:

..

Картинка архитектуры Hyper-V очень похожа на картинку архитектуры Xen. Говорят, что они, собственно, взяли все части Xen, которые позволила лицензия, а остальные переписали. Прозвучала также фраза "Linux с поддержкой Hyper-V" -- это, собственно, Linux over Xen, то есть ядро, обученное тому, что снизу у него лежит не железо, а гипервизор Xen. То есть гипервизор Hyper-V отдаёт вверх такой же интерфейс, как и Xen. Наводит на мысли.

..

Слайды доклада, кстати, тут - Построение отказоустойчивых систем на основе Hyper-V и кластеров Windows Server 2008 R2.

Траблшутинг ESXi

Из переписки.

Предыстория:

после отключения питания перестал загружаться ESXi 3.5 U2 сервер, ошибка:

Missing Operating System Boot Failure

(Сразу оговорюсь, железо на котором разворачивался ESXi, не входи в HCL). В качестве хранилища ВМ использовались локальные диски. На сервере крутились тестовые ВМ, но, не смотря на это, их потеря была крайне нежелательной. Поэтому первоочередным был вопрос восстановления ВМ.

Первое что вспомнилось – это возможность создания загрузочной флешки с ESXi, загрузившись с которой на упавшем сервере, можно было бы получить доступ к тому VMFS, и тем самым восстановить ВМ. Именно этот вариант и был реализован:

1. Создал загрузочную флешку с ESXi (http://www.vm4.ru/2008/01/esx-3i.html) , кстати, наткнулся на следующие грабли WinImage требует админских прав, иначе все работает нормально, но при выполнении Disk->Restore Virtual Hard Disk image on physical drive… недоступны съемные носители.

2. Загрузился с этой флешки на сервере, на котором упал ESXi. Для загрузки с флешки в BIOS произвел настройку USB, чтобы USB носитель воспринимался как жесткий диск, а не дискета (по умолчанию стоял второй вариант). После загрузки изменил сетевые настройки ESXi сервера, чтобы организовать доступ по сети.

3. Подключился к серверу с помощью VI Client и дальше я ожидал, что Хранилище подцепится автоматически, но этого не произошло. Хотя, как я понимал, VMFS тома автоматически подцепляются к ESXу. В разделе Storage Adapters были видны локальные диски, и в разделе Storage мне были доступны эти диски для создания VMFS тома. Здесь мне помог Михаил Михеев, большое спасибо, он посоветовал мне изменить параметр Advanced Settings -> LVM.EnableResignature в значение не по умолчанию. И…

4. УРА!!! Доступ к хранилищу получен, все ВМ спасены.

thx Айдар Фатыхов

Citrix XenServer 5 vs. ESX 3.5 U3

Решил завести у себя новый тег - "Сравнение".

Первое сообщени которое им помечено - это, и посвящено оно результатам сравнения Citrix XenServer 5 и VMware ESX 3.5 U3, под Citrix Xen App. В смысле, XenApp работает в виртуалках под этими гипервизорами.

Ссылка на документик - Citrix XenServer 5: Optimized Performance for XenApp Compared to VMware ESX 3.5u3, потребуется регистрация.

Вкратце - Citrix круче. По стечению обстоятельств, он же спонсор ;).

Master VCP

Есть мнение, что к существующим сегодня сертификациям VMware - VCP и VCDX будет добавлена еще одна, с примерным названием Master VCP.

Идея в чем:

VCP - условно массовый статус.

VCDX - элитный.

Не хватает чего то промежуточного. Вот о нем и речь.

VCP, VCDX… what’s next?

Пример траблшутинга медленной работы сети на VMware ESX

Интересный и достаточно подробный пример трабшутинга ESX - Troubleshooting VMware ESX network performance.

за подробностями - по ссылке, я же опишу вкратце.

Ситуация: сервера IBM x336, на них ESX.

Все хорошо, кроме одного - производительность сети зачем то составляет порядка половины а то и трети от ожидаемой.

В принципе, достаточно, и по этому поводу особо не парились.

Но ситуация изменилась, когда эти сервера перевели на работу с iSCSI SAN, вместо FC.

Дополнительно смущало, что на серверах Dell практически идентичной конфигурации такого проседания сети не было и в помине.

так же, если установить и использовать PCI сетевушки, вместо набортных - скорость возрастала до правильных значений.

Оказалось, что зачем то на одном прерывании с набортным бродкомом висел драйвер usb. Т.к. этот драйвер принадлежал SC, это прерывание обрабатывалось лишь одним ядром, CPU0. Это ядро обслуживало и SC, и сетевой стек набортных сетевушек для гипервизора. частые смены контекста, большие накладные расходы - и вот тормоза сети.

После выгрузки соответствующего драйвера скорость сети сравнялась с ожидаемой.

Но без USB тоже плохо - сервисный контроллер удаленного управления IBM RSA, Remote Server Administrator - удаленные мышь и клаву подключал именно как usb.

Из ситуации вышли достаточно забавно - был написан скрипт, который выгружал драйвер usb через 5 мниут после загрузки хоста.

Таким образом, если RSA нужен для траблшутинга - сервер ребутается, 5 минут после старта usb работает - этого времени хватает чтобы убить скрипт.

scvmm + esx

На заметку:

к бесплатному Hyper-V Майкрософт предлагает платную управлялку System Center Virtual Machine Manager, SCVMM.

Достаточно долго можно рассуждать на тему сравнения его с vCenter, но сейчас не об этом.

Сильной стороной SCVMM является то, что позволяет управлять, кроме непосредственно Hyper-V, еще и ESX серверами. Но, если для вас этот момент представляет интерес - будьте осторожны.

Во первых, VMM может управлять ESX хостами лишь через vCenter - т.е. он нам все равно потребуется.

А во вторых вот тут - Network World weighs in on SCVMM-VI3 Management - приводятся соображения(в т.числе с видеороликами) почему лучше бы он не умел управлять ESX'ми, ибо пока что это реализовано весьма коряво.

среда, 15 апреля 2009 г.

ITband

Коллеги, и в рамках обмена ссылками, и по делу хочу рассказать про ресурс

В частности, нам с вами в первую очередь могут быть интересны статьи про виртуализацию.

не выключается ВМ

В сентябре 2007 я написал пост что делать, если не получается выключить ВМ из GUI.

С тех пор проблема, когда нажимаешь "выключить ВМ", и виртуалка зависает в процессе выключения, и ни туда и ни сюда - такая проблема мне стала попадаться намного реже. Тем не менее, окончательно исключить ее нельзя. И я решил повторить этот список, заодно добавив один способ

Так что:

Если не получается выключить ВМ из GUI:

- Из командной строки выполнить команды -

vmware-cmd -l - для получения списка ВМ

vmware-cmd /vmfs/volumes///.vmx stop - попытка все таки корректно завершить работу. - Скорее всего, п.1 не поможет, тогда пробуем -

vmware-cmd /vmfs/volumes///.vmx stop hard

Это уже Power Off. - Мой опыт подсказывает, что уж если висим так висим, и пробовать надо более сильные средства:

vm-support -x - "x" маленький для получения списка ВМ

vm-support -X- "X" большой для убиения ВМ с соотв. ID - Последнее, что можно попробовать - убить процесс как процесс -

выполняем ps auxfww | grep имяВМ для узнавания process ID(PID)

выполняем kill -9 PID для непосредственно убития.

Это уже фаталити.

тюнинг под SQL

Коллеги, меня всегда чрезвычайно радует информация "с полей", максимально прикладная.

Сейчас меня порадовал камрад zubastiy который делится своими наработками по тюнингу настроек ВМ\VI под SQL - деградация производительности при виртуализации SQL2000.

Скопипастю:

Оптимизация дисковой системы.Как я понял, чуть ли не главным было:

Выравнивание разделов - http://www.vm4.ru/2009/03/vmfs-alignment.html

При установке по умолчанию sql складывает temp.db на диск C:\ бла бла

в том случае если системый раздел лежит на vmdk, а база на RDM - следует перенести temp.db на RDM

Либо, если для базы используете VMDK (небольшая нагрузка на дисковую)- тип диска следует сделать EagerZeroedThick (подробнее зачем это нужно - http://communities.vmware.com//thread/204046?tstart=0)

Если делать диски по умолчанию, в случае роста базы, логов - можно поиметь просадку производительности по дисковой. В принципе решаемо резерваций места силами самого sql

Настройки ESXi

Резервация оперативной памяти (можно не делать, если на хосте нет memory overcommit)

Назначение высокого значения дисковой шары (самый актуальный параметр для производительности 1С + sql2000 в большинстве типовых операций это быстродействие дисковой системы)

Резервация ядер процессоров (в том случае если будет использоваться не все ядра на хосте) - запретить выполнение любых операций кроме самой виртуалки, в том случае если этого не сделать, в этих ядрах могут выполнятся другие виртуалки и работать процессы самого ESXi (обслуживающие процессы) имеет смысл только в том случае если у виртуалки постоянно загружены процы и требуется выжать все что можно )

И помним про накопление статистики sql! Зачастую при миграции sql сервера на виртуальное железо, не смотря на более высокую производительность железок в следствии отсутствия статистики получаем результаты значительно хуже чем на старом железе (даже при виртуализации старого сервера - статистика накоплена для предыдущего железа).

выставление шар на диск, резервация памяти (свопфайл для виртуалки все равно создается, но равен 0) принесла свои результатыНу и к вопросу механизмов по работе с памятью:

по всем тестам 1-2 процента деградации производительности.

очень порадовал memory sharing при 1535 оперативки выданной sql - memory saving был в районе 800 mb

виртуализации sql силами ESX - быть )

UPD из комментариев.

главное - совокупность изменений )

"выравнивание" партиций дало общий прирост производительности, 2-3 процента дисковой для приложения.

шара, как я понял, дает приоритет дисковому траффику гостевой машины относительно нужд самого гипервизора, что повышает скорость отклика при рандомных операциях чтения/записи - немаловажный фактор при работе SQL

при линейном чтении-записи значение шары в моем случае не играло роли.

ну и по мелочи.

к примеру, при активном использовании SQL сервером временных таблиц узким местом было расположение tempdb - VMDK проигрывает по скорости отклика RDM

резервация ядер проца под виртуалку позволила получить memory sharing (по дефолту включен для всех виртуалок) без пенальти по процессорной мощности, процесс занимающийся обслуживанием memory sharing работал в других, менее загруженных ядрах, на втором проце, что дало еще немного производительности по процессору во время пиковой загрузки vCPU

увеличение глубины очереди в ESXi до 64 дало прирост при построении монструозных отчетов.

вторник, 14 апреля 2009 г.

Из комментариев к посту Типы дисков(vmdk файлов)

Из комментариев к посту Типы дисков(vmdk файлов):

навеяно http://communities.vmware.com//thread/204046?tstart=0thx камрад zubastiy.

решил провести тест для IOmetr

тестовый стенд ml150g3 - xeon 5110 + 5gb + 2 sata в набортном чипсете

esxi 3.5 upd 3 на флешке

ESXi винты видит как отдельные хранилища.

Системный раздел для виртуалки лежит на одном хранилище, тестовый диск - на втором, размер 50 gb

в самом IOmetr есть возможность отдать для теста сырую партицию или создать тестовый файлик заданного размера.

диск для тестов был создан zeroedthick

в тестах Iometer использовался тест «All in one»

отдал пустую партицию - 120 iops

создал тестовый файлик на весь диск - 150 iops

создал диск Eagerzeroedthick

в тестах Iometer использовался тест «All in one»

отдал тестовую партицию - 150 iops

создал тестовый файл на весь диск - 150 iops

вообщем то все как и говорил Anton V Zhbankov

zeroedthick следует предварительно разминать ))

либо сразу делать Eagerzeroedthick

понедельник, 13 апреля 2009 г.

тсссс

Скрины из четверки.

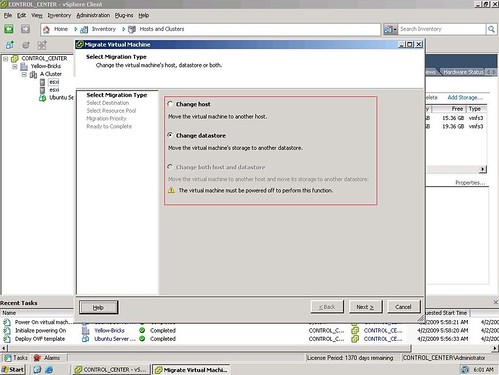

Storage vMotion из GUI:

Начало такое же - правый клик по ВМ и "Migrate"

Выбор как мигрировать теперь богатый

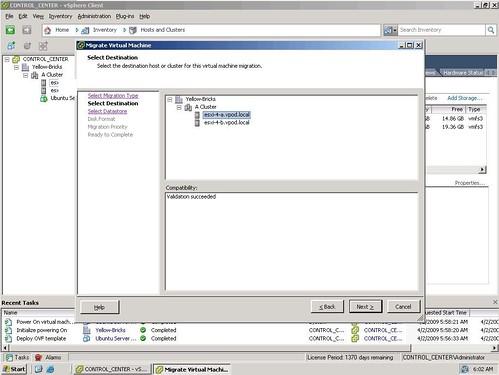

Выбор хоста

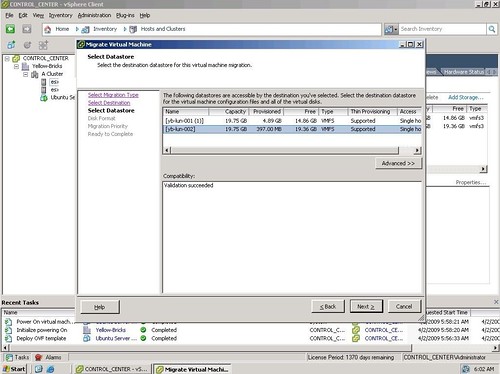

Выбор хранилища

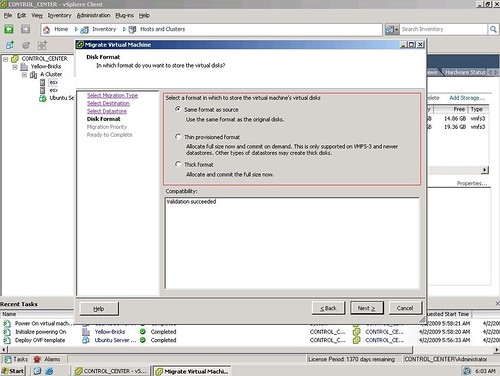

Выбор типа диска - thick или thin или без изменений

Приоритет

ползи ползи ползи…

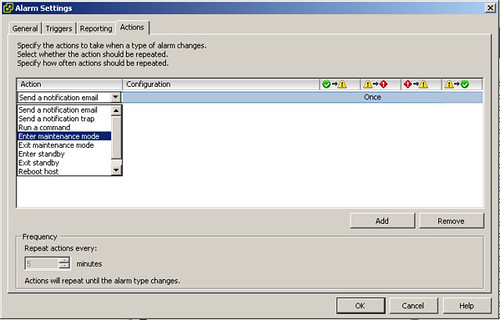

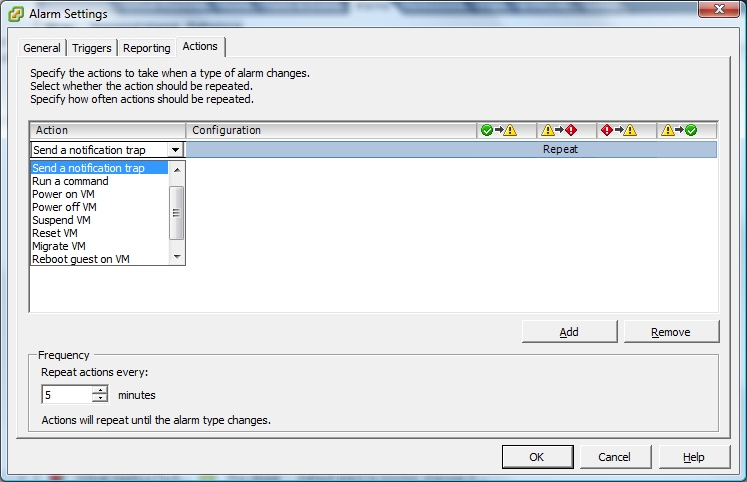

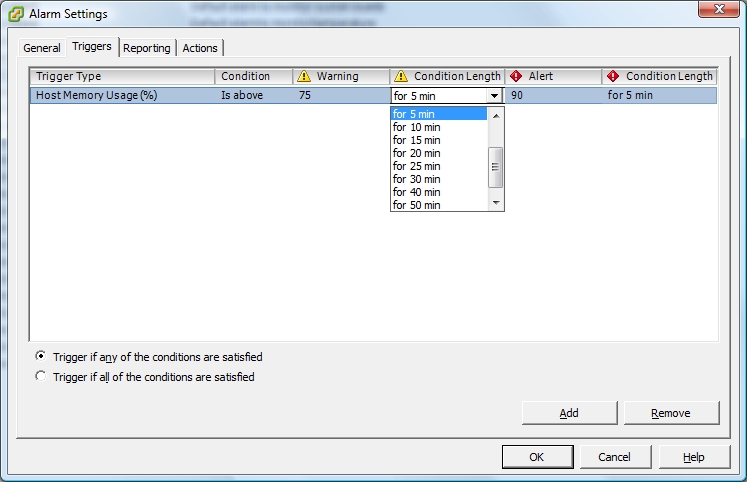

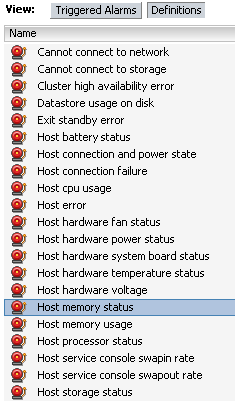

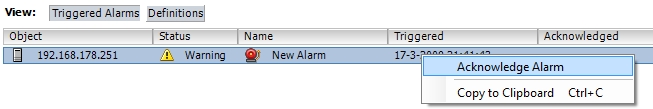

Алармы:

Богатство выбора реакции:

Продолжительность срабатывания можем указывать:

Кучу всего можем мониторить:

Можно делать так:

NDA нарушал Duncan Epping

Alarm Actions, exploring the new version of ESX/vCenter.

Storage VMotion, exploring the next version of ESX/vCenter.

воскресенье, 12 апреля 2009 г.

ссылки

Коллеги, камрад Serg перевел на русский доку по автоматизации установки ESX:

Remote and Scripted Installations ESX Server_p.1

Remote and Scripted Installations ESX Server_p.2

Полазав по его блогу, наткнулся на пару интересных ссылок:

Конвертируем виртуальную машину XEN в образ VMware.

Подключаем внешний USB диск к ESX Server.

суббота, 11 апреля 2009 г.

free ESXi & rcli

Лицензия ESXi бесплатна, но и менее функциональна, чем платные лицензии для ESX\ESXi.

Большинство ограничений можно отнести к разряду "инфраструктурных":

централизованное управление, vMotion, HA, DRS, VCB - всего этого нет для ESX\ESXi, отлицензированных бесплатной лицензией.

Зато для виртуализации как таковой, на одном хосте, ограничений не было - VMFS, vSMP, раздача ресурсов и т.п. - все есть и работает.

Единственный нюанс - для ESXi в штатном режиме работала удаленная командная строка, rCLI, но она не должна была работать на изменение - это ограничение бесплатной лицензии. Т.е. rCLI должна позволить получить данные, но не изменить какие то настройки.(это указано тут - VMware ESX and ESXi Comparison)

И, по видимому, начиная с Update 4, VMware таки закрыла возможность работы rCLI на изменение, в случае лицензирования бесплатной лицензией :(

Плохо это еще и потому, что какие то сторонние утилиты могут перестать работать с ESXi U4 с бесплатной лицензией.

vCenter Plugins

Недавно писал про плагины к vCenter - и список плагинов положил тут - http://wiki.vm4.ru/plugins.

Кстати, недавно узнал еще про один:

GuessMyOS Plug-in for VI3 - плагин к viCenter, позволяющий изменять иконки виртуальных машин в зависимости от гостевых ОС.

На блог про него раньше не писал.

И вот узнал о том, что еще три плагина под vCenter предлагает EMC - 3 EMC Plugins for VMware vCenter:

1) EMC Storage Viewer - This little gem allows some really great views all the way down into the array that’s underneath you hosts. Here’s a short video.

And here’s where you can grab it. Don’t forget the great whitepaper that goes along with it.

2) EMC Celera SRM Failback Tool - This one is awesome. If you’ve failed your environment over using VMware SRM then this tool will help you configure the storage to fail back to the original site. You can grab it here.

3) EMC Celera VDI Deployment - This will let you create a single VM on a share and then it will automatically clone that share out a bunch of times and automatically register the VMs in vCenter. Really nice way to scale out a bunch of VMs for VDI. It’s also available here.

Enjoy all of the new tools brought to you by our parent company, EMC.

Citrix XenServer

Итак, коллеги, последнее время активизировалась компания Citrix. Что я для себя узнал нового:

- Заявлено о разработке клиентского гипервизора. Не совсем понятно, что именно он из себя будет представлять, но картинку на конференции показывали а-ля ESXi - железка(Не сервер - ноут\десткоп. На Intel с поддержкой vPro), на железе гипервизор, поверх него - ВМ. В том смысле что на работе запускаем одну ВМ, офисную; дома - вторую, домашнюю. Ссылка - Project Independence

Очень похоже на то, что обещал Phoenix, но у того в итоге получилось совсем другое. - 07.04 обещан релиз бесплатности XenServer. Сейчас можно его скачать и лицензию дадут в нагрузку. Сейчас дают лицензию на 60 дней, а потом будут давать бессрочную.

Вот только что(11 апреля) посмотрел на citrix.com - ссылка на XenServer Free есть, можно скачать - 301 MB сам XenServer, еще 245 - Linux Guest Support. - Взаимоотношения Citrix и Microsoft в области виртуализации - такие же, как в области терминальных решений. Т.е. со стороны MS есть базовая функциональность, а Citrix предлагает все адвансед.

- Меня очень порадовала следующая фича: сервер, на сервер Citrix XenServer, на него установлена консоль от HP(работает только на серверах HP). Эта консоль является, фактически, графической консолью управления самим XenServer - как если бы на ESX'е запустить клиент VIС. Самая фишка, что на локальном мониторе могут отображаются консоли(!) ВМ, в том числе в виде миниатюр. Не сказать, что супернужно, но весьма прикольно. Эдакий KVM-switch, виртуальный.

- Скоро должна появиться бета следующей версии продукта, code-named "Project George", или XenServer 5.1. Список обещанных новых фич тут - XenServer "George" beta release - coming soon!.

конкретные фичи:

- Provisioning Server - организация pxe загрузки. Предоставляются средства для загрузки ВМ по сети. В рамках этой фичи заявляется возможность "балансировки нагрузки между физическими и виртуальными серверами" - в том смысле что если в ВМ стало не хватать ресурсов, то ее можно перезапустить на физическом сервере с того же PXE-шаблона. Вопросы загрузится ли образ(с т.зрения драйверов) не решаются.

- linux p2v прямо из дистрибутива xenserver.

- виртуалки хранятся в VHD формате. Поддерживается импорт OVF.

- интеграция в консоль(та что децентрализована и бесплатна) средств конфигурирования стораджей(с кем именно дружит пока не знаю) - что позволяет операции типа создания ЛУНа делать прямо из консоли Xen.

- заявлена поддержка USB - хостом, т.е. самим xen'ом.

- неплохая локальная консоль по дефолту - т.е. на локальном мониторе вы увидите меню а-ля БИОС - как в ESXi - но функционально оно богаче, чем у ESXi.

скрины:

- Если интересно посмотреть - я устанавливал XenSever в ВМ под Workstation. Запускать ВМ под Xen не получилось - все такие не ESX, требует VT .

Правда, там еще какой то linux-support-cd, может он бы с этим помог, для линукс гостей? - интерфейс не web, нужен клиент под винду. Наверное, есть клиент и под Linux.

Из известных мне гадостей про Citrix Xen:

- не очень хорошая ситуация с бекапом. У VMware есть VCB - не идеальное, но мощное средство организации резервного копирования ВМ, с богатым функционалом. Который , причем, развивают, и в вСфере он будет еще богаче.

У Citrix сегодня нет ничего. - Ситуация с самим Xen - тут я не большой специалист, но насколько уяснил, ситуация следующая:

open source комьюнити переключается на гипервизор KVM, который вроде как значительно интереснее Xen'а, в силу молодовизны и оптимизированности. Он включается в состав дистрибутивов(см., например, Виртуализация: планы Red Hat). Включается сначала вместе, а потом вместо Xen. Таким образом, если сейчас за Xen стоит Citrix и сообщество, то в перспективе - только Citrix.

Есть мнение, что это не очень хорошо для продукта.

VMware tools

VMware Tools FAQ - ответы на некоторые вопросы, и перечисление входящего в состав VMwareTools:

- vmmemctl - Balloon driver.

- vmxnet - Paravirtualized network VMwaredriver.

- vmblock - Block filesystem driver to provide drag-and-drop functionality from the remote console.

- vmsync - Sync driver for freezing and thawing filesystems (Linux specific).

- vmhgfs - VMware host/guest file system driver (not used within ESX).

- SVGA Display Driver for Windows systems.

- Mouse Driver for Windows systems.

- vmdesched - Experimental driver for improving time keeping.

- vsock - Socket driver that works with VMCI.

- VMware Guest Daemon for controlling communication between the guest and the host including time sychronization.

- VMware Toolbox for Linux or VMware Tray for Windows for controlling various VMware Tools settings.

vMotion CPU compatibility - EVC

Для живой миграции - vMotion - есть два самых потенциально проблематичных условия:

наличие разделяемой системы хранения

и совместимых процессоров.

К счастью, ситуация с процессорами давно и уверенно меняется к лучшему, и уже начиная с VI 3.5 U2 у нас появилась возможность пользоваться EVC - Enhanced VMotion Compatibility.

C т.зрения VI это свойство(или функция) DRS кластера. Когда мы для DRS кластера ее включаем - процессоры хостов настраиваются таким образом, чтобы обеспечить совместимость процессоров для vMotion.

Информация и ссылки по теме доступны в kb - Enhanced VMotion Compatibility (EVC) processor support.

В частности, там указаны модели процессоров Intel и AMD, которые обладают совместимостью по EVC(правда, смотрел смотрел я на эту табличку - так и не догнал что она пытается сказать %)

Обратите внимание:

Мигрировать МЕЖДУ Intel и AMD нельзя.

Мигрировать между Intel-Intel может быть можно, а может и нет - есть определенные границы совместимости. У AMD вроде как совместимость полная.

Если есть CPU с поддержкой EVC(это значит, в CPU есть фича Intel FlexMigration или AMD-V Extended Migration ), и процессоры без оной, то вроде как более новые процы сумеют таки подстроится под старые.

MSCS + ESX

Поднятие отказоустойчивых кластеров между ВМ(с упором на кластер Майкрософт как самое популярное решение) - что для этого надо настроить и какие ограничения -

Setup for Microsoft cluster service.

VI Toolkit

Презентация в 10 слайдов про VI toolkit - кто не знает зачем это может быть интересно - VI Toolkit Presentation.

ESX unattended installation

Коллеги, напомню:

если для ESXi у нас есть возможность просто загружать его по PXE(жаль, не поддерживаемая), то для ESX мы так не можем. Зато можем установить ESX с загрузкой сервера по сети, файлом ответов и скриптом для любой дальнейшей настройки.

Об это немного по русски и правильные ссылки на тему тут - Автоматическая инсталляция ESX.

пятница, 10 апреля 2009 г.

Типы дисков(vmdk файлов)

Коллеги, напомню, что у дисков ВМ - vmdk файлов - есть несколько типов:

- Когда размечаются блоки под них

- когда затираются блоки(обнуляются, zeroed).

| ZeroedThick | Thick | EagerZeroedThick | Thin | |

| Разметка | При создании | При создании | При создании | По запросу |

| Обнуление | При первой операции записи на блок | Нет | При создании диска | Перед первой операцией записи |

| Используется в случае | Во всех типовых | Для кворумных дисков MSCS | Для кворумных дисков MSCS (дольше создается, чем в формате Thick, но является более рекомендованным) | Когда хотим поэкономить место на LUN. Если vmdk создается на NFS хранилище, то по умолчанию он создается в этом формате . |

обратите внимание:

Thin диски используются на NFS - без вариантов, но не поддерживаются на FC SAN.

ZeroedThick диски дают задержку при первом обращении к блоку. Сложно сказать, насколько это замедляет работу в производственной среде, но на тестах явно заметно - см. тему на официальном русскоязычном форуме - http://communities.vmware.com//thread/204046?tstart=0. Так что, в производственной среде под важные машинки может иметь смысл использовать eagerzeroedthick диски - их единственный минус в том, что они долго создаются. Или thick - их минус в том, что блоки не обнуляются перед использованием - правда, я не знаю конкретики, почему это плохо.

Сама VMware позиционирует их так:

- ZeroedThick - тип по умолчанию. В нем создаются vmdk, когда мы их делаем из VIC. Самый используемый.

- Thick - для кворумных дисков MSCS, когда кластер поднимается для поиграться.

- EagerZeroedThick - для кворумных дисков MSCS, когда кластер поднимается в эксплуатацию.

- Thin- динамический. Занимает места только столько, сколько реально занято гостевой ОС, в отличие от всех других.

Как их создать -

Создание тонких (растущих по мере наполнения) дисков на VMware ESX Server 3.5.

Правда, есть мнение, что эффективность тонких, thin, дисков может быть не очень большой, в некоторых ситуациях. Процитирую один из старых своих постов - VMware View - это все о нем - речь, правда, в нем идет про Linked Clones, но суть та же:

А следующий пост - критика основы метода экономии места на сторадже - VMware View - Linked Clones Not A Panacea for VDI Storage Pain!.

Идея в том, что дельты, которые создаются для каждой ВМ, очень быстро вырастают до номинального размера диска ВМ. Каждая дельта. Автор ссылается на свои собственные тесты. Причину он видит в особенности работы NTFS - которая сначала использует обнуленные блоки, и только за их отсутствием будет использовать те, которые заняты удаленными файлами. Например - если мы создадим и сразу удалим файл в 1 ГБ 10 раз подряд, то с т.зрения гостевой ОС у нас свободного места как было, так и осталось. А снапшот(файл дельта) вырос на 10 ГБ.

Таким образом, вещи типа временных интернет файлов, да и вообще любых временных файлов, от того же офиса; кэши дистрибутивов софта и патчей, данные для деинсталляции патчей и т.п... Все это приведет, даже привОдит к быстрому росту дельты.

Наконец, дельты увеличиваются. Увеличиваются блоками по 16 МБ. И каждое увеличение требует резервирования LUN хостом с этой ВМ. Таким образом, на один LUN положив много VDI машин в Liked Clone режиме, мы можем получить снижение производительности из за этих паразитных блокировок LUN'а.

Так что мне очень интересно было бы услышать отзывы на эту тему, если кто использует активно thin диски у себя.

vCenter + ESX через WAN

Если вдруг возникла нужда управлять через vCenter далеко стоящим ESX сервером, то может пригодится статья - Proven Practice: ROBO - Managing Remote ESX Hosts Over WAN with VirtualCenter.

txh Alexander Sobolev.

среда, 8 апреля 2009 г.

результаты тестирования разных гипервизоров

В комментариях поделились ссылочкой на результаты тестирования разных гипервизоров - Тестирование производительности систем виртуализации ESXi, KVM, Xen.

Итого:

Если я правильно понял, то Windows в ВМ подо всеми гипервизорами, кроме ESXi, с диском работают быстрее, чем с этими дисками работает Windows на самой железке.

thx камрад Анонимный.

Вообще, сдается мне, тестировать имеет смысл по другому - так, как это делает, к примеру VMware:

Раз виртуализация нужна не для запуска одной ВМ на сервере, а для запуска пачки ВМ - так много и надо запускать.

Брать какой либо тест, определять допустимые показания - обычно время отклика берется, если речь идет о приложении - и потом смотрится - а сколько ВМ одновременно с удовлетворительной скоростью могут работать.

пример из жизни

Углядел еще один пример из жизни, почему виртуализация это хорошо, но не все средства виртуализации хороши :

Некоторый хистори издалека к сравнению и выбору... Недавно обзаботившись легализацией используемой 1С-ой софтины "Трактиръ" в клубе приобрели SBS 2008 Premium с целью заменить имеющийся насквозь "кривой" 2000-й MS-сервер и 2000-й MS-SQL Std (необходимость SQL вызвана конфигурацией 1С, зачем она была куплена не спрашивайте - выбрано было до моего прихода). Общий Выбор SBS Premium был обусловлен ценой на комплект сервер+SQL. Причём весь этот комплект планировался установиться "по минимому" на один единственный существующий "сервер" (по сути легализация имеющегося, для 6-и малоактивных клиентов в развлекательном клубе). Далее началась "веселуха", приведшая к виртуализации :) О том, что SQL из комлекта ставится ТОЛЬКО на отдельный сервер и в составе домена SBS, разумеется ни сайт MS, ни авторизованный в MS местный поставщик не сообщил... В результате получив все получившиеся дитсрибутивы и оказавшись перед фактом, что только 2-а сервера и никак иначе, начал искать возможные варианты. Логичный вариант 2-х физических серверов отмёлся изначально, ибо на 6-ть малоактивных пользователей это глубокий нонсенс. Поэтому сначала выплыл вариант виртуализировать необходимый КД "родным" Hyper-V, и причём поскольку этот КД из состава был нужен только на авторизацию клиентов в домене и установку SQL то он и естественным образом наметился на виртуализацию. Первый "облом" встретился сразу - КД из SBS для установки требует 4Гб ОЗУ, но по источникам в интернете далее прекрасно работает на 512Мб. Поскольку имеющийся сервер и так имел 4Гб ОЗУ, то Hyper-V к глубокому разочарованию категорически отказался делать memory overcommit для гостевого КД... Расширять ОЗУ было некуда (физически), вариант с ESXi к глубокому разочарованию отмёлся сразу - сервер "самосбор" на неподдерживаемом оборудовании. С "экзотикой" XEN связываться было несколько несподручно и некогда. В общем-то поэтому естественным образом пришёл к Virtual Server 2.0 (ранее имел дело с ESXi). Поставив VS2.0 был приятно поражён как стабильностью, так и получившимся результатом: во-первыйх доступен необходимый memory overcommit, КД встал "на ура", SQL тоже без проблем, администрирование "интуитивно" в домене SBS, всё работает просто на "ура" (разумеется для имеющегося оборудования и задачи!).thx камрад Анонимный.

В общем после этого как-то к решениям от MS в плане построения системы при минимальном бюджете как-то сильно охладел...

Все про VMFS - трабшутинг, восстановление, рекомендации, настройки

Коллеги - рекомендую:

про vmfs, про восстановление vmfs в случае проблем, на русском и с ссылками по теме - VMind - Устройство VMFS-раздела.

Ну и заодно подборка прочих русскоязычных ссылок:

- VMFS - у меня на wiki.

- Обобщение опыта переезда и решения проблем с VMFS.

- VMFS Heap Size для VMware ESX / ESXi.

на случай если совокупный обьем vmdk файлов превышает 4 Террабайта. - Выбор размера VMFS раздела под ВМ

Рекомендации по созданию LUN для ESX.

Выбор размера тома VMFS для размещения виртуальных машин VMware ESX / ESXi. - Выбор размера блока VMFS (вкратце - танцуем лишь от предполагаемого максимального обьема vmdk на разделе, на производительность размер блока не влияет)

Выбор размера блока для файловой системы VMFS для VMware ESX Server. - Как работает VMFS, для чего нужны блоки и как они влияют на тонкие vmdk для VMware View.

- доступ к VMFS из под Windows\Linux и оно же

Свободный драйвер для кластерной файловой системы VMFS от VMware. - Дефрагментация VMFS.

- Мониторинг свободного места на VMFS разделах.

До кучи:

Не русскоязычные, зато официальные